Makine öğrenimi, her türlü sorunu çözmek için derin bir araç kutusu sunar, ancak hangi araç hangi görev için en iyisidir? Açık uçlu anahtar ne zaman ayarlanabilir türden daha iyidir? Bu şeyleri kim icat etti? Bu bölümde en kullanışlı altı algoritmayı inceliyoruz: nereden geldikleri, ne yaptıkları ve AI toplumun her alanına girerken nasıl geliştikleri.

Doğrusal Regresyon: Düz ve Dar

Doğrusal regresyon, makine öğreniminde anahtar istatistiksel yöntem olabilir. İki seçkin matematikçi bu algoritmanın kendilerinin olduğu iddia ettiler ve 200 yıl sonra bile bu mesele çözülmedi.

Kimin algoritması? 1805'te Fransız matematikçi Adrien-Marie Legendre, bir dizi noktaya bir çizgi uydurma yöntemini yayınladı. Bir kuyruklu yıldızın yerini tahmin etmeye çalışıyordu. (Göksel navigasyon, o zamanlar küresel ticarette en değerli bilimdi, tıpkı bugün olduğu gibi - yeni elektrik, eğer istersen, elektrik motorundan yirmi yıl önce.) Dört yıl sonra, 24 yaşındaki Alman harikası Carl Friedrich Gauss, 1795'ten beri aynı yöntemi kullandığında ısrar etti, ancak bunun hakkında yazamayacak kadar önemsiz olduğunu düşündü. Gauss'un iddiası, Legendre'yi, "çok ünlü bir geometri uzmanının bu yöntemi benimsemekten çekinmediğini" gözlemleyen isimsiz bir zeyilname yayınlamaya sevk etti.

Eğimler ve sapmalar: Doğrusal regresyon, bir sonuç ile onu etkileyen bir değişken arasındaki ilişkinin düz bir çizgi izlediği her durumda faydalıdır. Örneğin, bir arabanın yakıt tüketimi, ağırlığı ile doğrusal bir ilişki içindedir.

- Yakıt tüketimi y ve araba ağırlığı x arasındaki ilişki , hattın eğimine w (yakıt tüketiminin ağırlıkla ne kadar dik arttığına) ve sapma terimi b'ye (sıfır ağırlıkta yakıt tüketimi): y=w*x+b'ye bağlıdır .

- Eğitim sırasında, bir arabanın ağırlığı verildiğinde, algoritma beklenen yakıt tüketimini tahmin eder. Beklenen ve gerçek yakıt tüketimini karşılaştırır. Ardından, tipik olarak w ve b değerlerini ele alarak sıradan en küçük kareler tekniği yoluyla kare farkını en aza indirir.

- Aracın sürtünmesini hesaba katmak daha kesin tahminler üretmeyi mümkün kılıyor. Ek değişken, çizgiyi bir düzleme genişletir. Bu şekilde, doğrusal regresyon herhangi bir sayıda değişkeni/boyutu barındırabilir.

Her yerde bulunan iki adım: İki başka gelişme, algoritmanın geniş potansiyelini ortaya çıkardı. 1922'de İngiliz istatistikçiler Ronald Fisher ve Karl Pearson, lineer regresyonun korelasyon ve dağılımın genel istatistiksel çerçevesine nasıl uyduğunu göstererek, onu tüm bilimlerde faydalı hale getirdi. Ve yaklaşık bir yüzyıl sonra, bilgisayarların ortaya çıkışı, ondan çok daha fazla yararlanmak için veri ve işlem gücünü sağladı.

Belirsizlikle başa çıkma: Elbette, veriler hiçbir zaman tam olarak ölçülemez ve bazı değişkenler diğerlerinden daha önemlidir. Hayatın bu gerçekleri daha karmaşık varyantları teşvik etti. Örneğin, düzenlileştirmeli doğrusal regresyon ( sırt regresyonu olarak da adlandırılır ), doğrusal bir regresyon modelini herhangi bir değişkene çok fazla bağımlı olmamaya veya daha doğrusu en önemli değişkenlere eşit olarak güvenmeye teşvik eder. İyi bir varsayılan seçimdir. Basitlik için gidiyorsanız, farklı bir düzenlileştirme biçimi (L2 yerine L1) lasso (least absolute shrinkage and selection operator) ile sonuçlanır; mümkün olduğu kadar çok katsayıyı sıfır olmaya teşvik eder. Yani tahmin gücü yüksek değişkenleri seçmeyi öğrenir ve gerisini yok sayar. Elastik ağ (Elastic Nets), her iki düzenleme türünü de birleştirir. Veriler seyrek olduğunda veya özellikler ilişkili göründüğünde kullanışlıdır.

Her nöronda: Yine de basit versiyon son derece faydalıdır. Bir sinir ağındaki en yaygın nöron türü, lineer bir regresyon modeli ve ardından lineer olmayan bir aktivasyon fonksiyonudur ve lineer regresyonu derin öğrenmenin temel bir yapı taşı haline getirir.

Lojistik Regresyon: Eğriyi Takip Edin

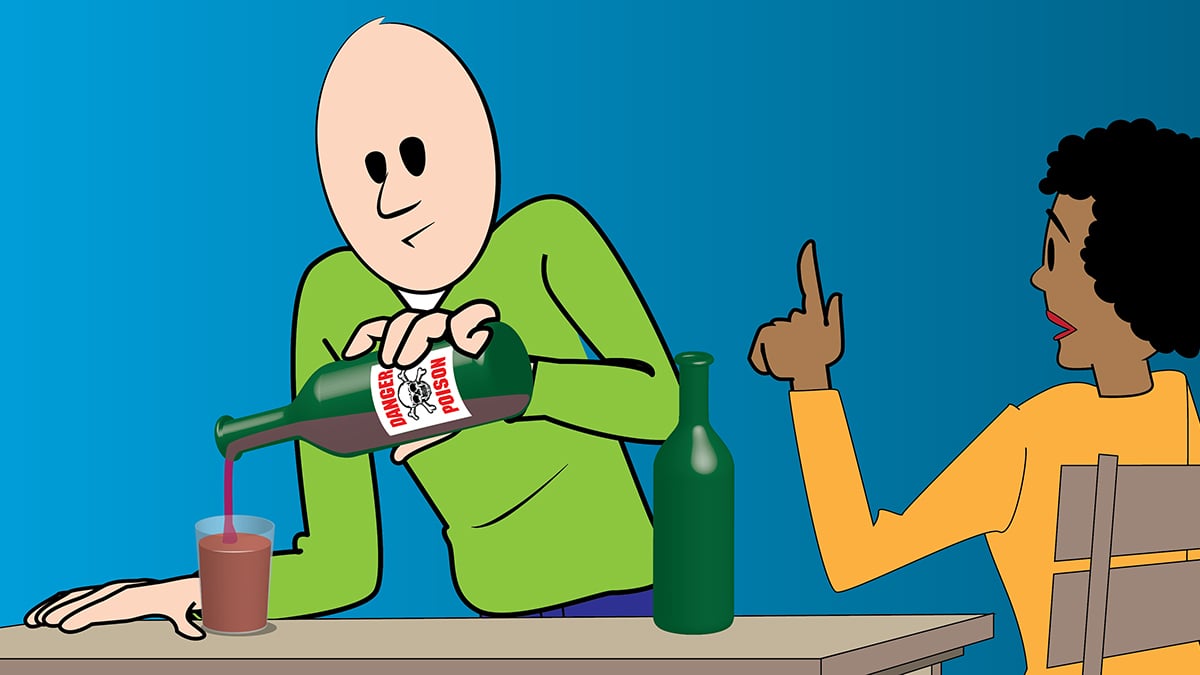

Lojistik regresyonun tek bir şeyi sınıflandırmak için kullanıldığı bir an vardı: Bir şişe zehir içerseniz, muhtemelen “yaşayan” veya “öldü” olarak etiketlenir misiniz? Zaman değişti. Bugün acil servisleri aramak gibi alternatiflerimiz de var. Buda soruya daha iyi bir yanıt sağlıyor ve lojistik regresyon, derin öğrenmenin tam kalbinde yer alıyor.

Zehir kontrolü: Lojistik işlevi, Belçikalı istatistikçi PF Verhulst'ün nüfus dinamiklerini tanımlamak için icat ettiği 1830'lara kadar uzanır: Zamanla, üstel büyümenin ilk patlaması, mevcut kaynakları tüketirken düzleşir ve karakteristik lojistik eğri ile sonuçlanır. Amerikalı istatistikçi EB Wilson ve öğrencisi Jane Worcester'ın belirli bir tehlikeli maddenin ne kadarının ölümcül olacağını bulmak için lojistik regresyon geliştirmesinden önce bir yüzyıldan fazla zaman geçti.

Fonksiyonu uydurma: Lojistik regresyon, belirli bir sonucun (örneğin, zamansız bir ölüm) meydana gelme olasılığını (örneğin, striknini (etkili bir zehir) yutmak) bir olay verildiğinde tahmin etmek için bir veri kümesine lojistik fonksiyonu uyarlar.

- Eğitim, fonksiyonun çıktısı ile veriler arasındaki hatayı en aza indirmek için eğrinin merkez konumunu yatay olarak ve ortasını dikey olarak ayarlar.

- Merkezi sağa veya sola ayarlamak, ortalama bir insanı öldürmek için az çok zehir gerekeceği anlamına gelir. Dik bir eğim, kesinlik anlamına gelir: Yolun yarısından önce çoğu insan hayatta kalır; orta noktanın ötesinde iseniz "elveda". Hafif bir eğim daha bağışlayıcıdır: eğrinin ortasından daha aşağıda, yarısından fazlası hayatta kalır.

- Bir sonuç ile diğeri arasında 0,5'lik bir eşik belirleyin ve eğri bir sınıflandırıcı haline gelir. Sadece dozu modele girin ve bir parti mi yoksa cenaze mi planlamanız gerektiğini bileceksiniz.

Daha fazla sonuç: Verhulst'un çalışması, bir zehir kurbanının öbür dünyanın hangi tarafına düşebileceği gibi diğer olasılıkları göz ardı ederek ikili sonuçların olasılıklarını buldu. Ardışıkları algoritmayı genişletti.

- 1960'ların sonlarında bağımsız olarak çalışan İngiliz istatistikçi David Cox ve Hollandalı istatistikçi Henri Theil , ikiden fazla olası sonucu olan durumlar için lojistik regresyonu uyarladılar.

- Daha fazla çalışma , sonuçların sıralı değerler olduğu sıralı lojistik regresyon verdi.

- Seyrek veya yüksek boyutlu verilerle başa çıkmak için lojistik regresyon, doğrusal regresyonla aynı düzenlileştirme tekniklerinden yararlanabilir.

Çok yönlü eğri: Lojistik fonksiyon, geniş bir fenomen yelpazesini adil bir doğrulukla tanımlar, bu nedenle lojistik regresyon, birçok durumda kullanışlı temel tahminler sağlar. Tıpta, ölüm ve hastalık riskini tahmin eder. Siyaset biliminde, seçimlerin kazananlarını ve kaybedenlerini tahmin eder. Ekonomide, iş beklentilerini tahmin eder. Daha da önemlisi, çok çeşitli sinir ağlarında doğrusal olmayan bir sigmoid olduğu nöronların bir kısmını çalıştırır.

Gradyan İnişi: Her Şey Yokuş Aşağı

Alacakaranlıktan sonra dağlarda yürüyüş yaptığınızı ve ayaklarınızın ötesini göremediğinizi hayal edin. Ve telefonunuzun pili bittiği için eve dönüş yolunu bulmak için bir GPS uygulaması kullanamazsınız. Gradyan iniş yoluyla en hızlı yolu bulabilirsiniz. Sadece uçurumdan düşmemeye dikkat edin.

Güneşler ve kilimler: Fransız matematikçi Augustin-Louis Cauchy, 1847'de yıldızların yörüngelerini tahmin etmek için algoritmayı icat etti. Altmış yıl sonra, yurttaşı Jacques Hadamard bağımsız olarak, aşağı doğru yürümeyi kolaylaştırabilecek kilim gibi ince, esnek nesnelerin deformasyonlarını tanımlamak için geliştirdi. Bununla birlikte, makine öğreniminde en yaygın kullanımı, bir öğrenme algoritmasının kayıp fonksiyonunun manzarasındaki en düşük noktayı bulmaktır.

Aşağı doğru inmek: Eğitilmiş bir sinir ağı, bir girdi verildiğinde istenen bir çıktıyı hesaplayan bir fonksiyon sağlar. Ağı eğitmenin bir yolu, gerçek ve istenen çıktı arasındaki farkı yinelemeli olarak hesaplayarak ve ardından farkı daraltmak için ağın parametre değerlerini değiştirerek çıktısındaki kaybı veya hatayı en aza indirmektir. Gradyan iniş bunu, kaybı hesaplayan işlevi en aza indirerek gerçekleştirir.

- Ağın parametre değerleri, manzara üzerindeki bir konuma eşittir ve kayıp, mevcut irtifadır. Aşağı indikçe, ağın istenen çıktıya yakın çıktıları hesaplama yeteneğini geliştirirsiniz. Görünürlük sınırlıdır, çünkü tipik bir denetimli öğrenme durumunda, algoritma yalnızca ağın parametre değerlerine (tepedeki konumunuz) ve eğime (hemen ayaklarınızın altındaki eğim) dayanır.

- Temel yöntem, arazinin en dik indiği yönde hareket etmektir. İşin püf noktası, adımınızı kalibre etmektir. Çok küçük ve herhangi bir ilerleme kaydetmek uzun zaman alıyor. Çok büyük ve bilinmeyene atlıyorsunuz, muhtemelen aşağı değil yokuş yukarı gidiyorsunuz.

- Mevcut konum göz önüne alındığında, algoritma kayıp fonksiyonunun gradyanını hesaplayarak en dik inişin yönünü tahmin eder. Gradyan, yokuş yukarıyı gösterir, bu nedenle algoritma, gradyandın bir kısmını çıkararak ters yönde ilerler. Öğrenme oranı olarak adlandırılan α kesri , gradyanı tekrar ölçmeden önce adımın boyutunu belirler.

- Bunu tekrar tekrar uygulayın ve umarım bir vadiye ulaşırsınız.

Vadide mahsur kalmak: Algoritma sizi dışbükey bir dağın dibine itmemiş olabileceğinden, telefonunuzun şarjının bitmesi çok kötü. Bunun yerine, birden fazla vadi (yerel minimum), tepe (yerel maksimum), eyer (semer noktaları) ve platolardan oluşan dışbükey olmayan bir manzarada sıkışıp kalabilirsiniz. Aslında, görüntü tanıma, metin oluşturma ve konuşma tanıma gibi görevler dışbükey değildir ve bu tür durumları ele almak için gradyan inişinde birçok varyasyon ortaya çıkmıştır. Örneğin, algoritma, küçük yükselişler ve düşüşler üzerinde yakınlaşmasına yardımcı olan bir momentuma sahip olabilir, bu da ona dibe ulaşmak için daha iyi bir şans verir. Neyse ki, yerel ve küresel minimumlar kabaca eşdeğer olma eğilimindedir.

Optimal optimize edici: Gradyan iniş, herhangi bir fonksiyonun minimumunu bulmak için net bir seçimdir. Kesin bir çözümün doğrudan hesaplanabildiği durumlarda - örneğin, çok sayıda değişken içeren bir doğrusal regresyon görevi - yaklaşık bir tane olabilir, genellikle daha hızlı ve daha ucuza (daha az maliyete) mal olur. Ancak karmaşık, doğrusal olmayan görevlerde gerçekten kendine gelir. Eğimli bir iniş ve maceracı bir ruhla donanmış olarak, akşam yemeği için zamanında dağlardan çıkabilirsiniz.

Sinir Ağları: Fonksiyonu Bulun

Bunu aradan çıkaralım: Beyin, bir grafik işleme birimleri kümesi değildir ve öyle olsaydı, tipik yapay sinir ağından çok daha karmaşık yazılımlar çalıştırırdı. Yine de sinir ağları beynin mimarisinden ilham aldı: her biri komşularının durumlarına bağlı olarak kendi çıktısını hesaplayan birbirine bağlı nöron katmanları. Ortaya çıkan aktivite dizisi bir fikir oluşturur - veya bir kedinin resmini tanır.

Biyolojiden yapaya: Beynin nöronlar arasındaki etkileşimler yoluyla öğrendiği anlayışı 1873'e kadar uzanıyor, ancak 1943'e kadar Amerikalı sinirbilimciler Warren McCulloch ve Walter Pitts biyolojik sinir ağlarını basit matematiksel kurallar kullanarak modellemedi. 1958'de Amerikalı psikolog Frank Rosenblatt , Birleşik Devletler Donanması için bir donanım versiyonu oluşturmak amacıyla delikli kartlarda uygulanan tek katmanlı bir görüş ağı olan perceptron'u geliştirdi.

Daha büyük daha iyidir: Rosenblatt'ın icadı yalnızca bir çizgiyle ayrılabilen sınıfları tanıdı. Ukraynalı matematikçiler Alexey Ivakhnenko ve Valentin Lapa , nöron ağlarını herhangi bir sayıda katmanda istifleyerek bu sınırlamanın üstesinden geldi . 1985 ve 1986'da bağımsız çalışan Fransız bilgisayar bilimcisi Yann LeCun, David Parker ve Amerikalı psikolog David Rumelhart ve meslektaşları , Fin matematikçi Seppo Linnainmaa ve Amerikalı sosyal bilimci Paul Werbos'un daha önceki çalışmalarını takiben, sinir ağlarını verimli bir şekilde eğitmek için geri yayılımı kullanmayı tanımladılar. 2000'lerde Kumar Chellapilla, Dave Steinkraus ve Rajat Raina (Andrew Ng ile birlikte) dahil olmak üzere araştırmacılar çalışmalarını hızlandırdılar (bilgisayar grafiklerini veya grafik işlem birimlerini hızlandırmak için tasarlanmış yongaları kullanan sinir ağları). Bu gelişme, her zamankinden daha büyük sinir ağlarının internet tarafından üretilen muazzam miktarda veriden öğrenmesini sağladı.

Her görev için uygundur: Bir sinir ağının arkasındaki fikir basittir: Herhangi bir görev için onu gerçekleştirebilecek bir işlev vardır. Bir sinir ağı, her biri tek bir nöron tarafından yürütülen birçok basit işlevi birleştirerek eğitilebilir bir işlev oluşturur. Bir nöronun işlevi, ayarlanabilir parametrelerle belirlenir (ağırlıklar da denir). Rastgele parametre değerleri ve girdi örnekleri ve bunların istenen çıktıları verildiğinde, eğitilebilir işlev eldeki görevi gerçekleştirene kadar bu değerleri yinelemeli olarak değiştirmek mümkündür.

- Bir nöron çeşitli girdileri kabul eder (örneğin, bir pikseli veya kelimeyi temsil eden sayılar veya önceki katmanın çıktıları), bunları parametre değerleriyle çarpar, ürünleri ekler ve toplamı doğrusal olmayan bir fonksiyon veya seçilen aktivasyon fonksiyonu aracılığıyla besler. Bunu lineer regresyon artı bir aktivasyon fonksiyonu olarak düşünün.

- Eğitim parametre değerlerini değiştirir. Her örnek girdi için ağ bir çıktı hesaplar ve bunu beklenen çıktıyla karşılaştırır. Geri yayılım, gerçek ve beklenen çıktılar arasındaki farkı azaltmak için değerleri değiştirmek için gradyan inişini kullanır. Yeterli (iyi) örneklerle bu işlemi yeterince kez tekrarlayarak ağ görevini yaparak öğrenmeyi tamamlar.

Sağduyuya doğru: 1958'de Rosenblatt'ın Perceptron'u hakkında haber yapan The New York Times , onu “Birleşik Devletler Donanmasının yürüyebileceğini, konuşabileceğini, görebileceğini, yazabileceğini, kendini yeniden üretebileceğini ve varlığının bilincinde olmasını beklediği bir elektronik bilgisayarın embriyosu” olarak adlandırdı. ” Bu faturayı karşılayamasa da, Go oynamada insan seviyesindeki performansı aşmış ve röntgen görüntülerini teşhis etmede ona yaklaşmış modeller doğurdu. Yine de sinir ağları sağduyu ve mantıksal akıl yürütme ile hala zor anlar yaşıyor. GPT-3'e "Sayarken bir milyondan önce hangi sayı gelir?" diye sorun. ve "Dokuz yüz bin doksan dokuz bir milyondan önce gelir" diye cevap verebilir.

Karar Ağaçları: Kökten Yaprağa

Aristoteles nasıl bir canavardı? Üçüncü yüzyılda Suriye'de yaşayan filozofun takipçisi Porphyry, soruyu cevaplamak için mantıklı bir yol buldu. Aristoteles'in önerdiği “varlık kategorileri”ni genelden özele doğru düzenledi ve sırayla her kategoriye Aristoteles'in kendisini atadı: Aristoteles'in tözü kavramsal ya da tinsel olmaktan ziyade mekânı işgal etti; bedeni cansız değil, canlıydı; zihni rasyoneldi, irrasyonel değil. Böylece sınıflandırması insandı. Ortaçağ mantık öğretmenleri, diziyi dikey bir akış şeması olarak çizdi: Erken bir karar ağacı.

Dijital fark: Michigan Üniversitesi'nden sosyolog John Sonquist ve ekonomist James Morgan'ın ankete katılanları gruplara ayırarak ilk kez uygulamaya koyduğu 1963'e hızlı ileri Bilgisayardaki karar ağaçları. Bu tür çalışmalar, artık scikit-learn dahil olmak üzere çeşitli makine öğrenimi kitaplıklarında bulunan algoritma eğitimini otomatikleştiren yazılımın ortaya çıkmasıyla olağan hale geldi. Kodun geliştirilmesi Stanford ve UC Berkeley'deki bir dörtlü istatistikçinin 10 yılını aldı. Bugün, bir karar ağacını sıfırdan kodlamak Machine Learning 101'de bir ev ödevidir.

Gökyüzündeki kökler: Bir karar ağacı sınıflandırma veya regresyon yapabilir. Girdi örneklerini iki (veya daha fazla) gruba ayıran bir kararlar hiyerarşisinde kökten tepeye doğru aşağı doğru büyür. Maymunları maymunlardan (insanları bir kenara bırakarak) ilk kez 1776'da ayıran ve daha önce birlikte kategorize eden Alman doktor ve antropolog Johann Blumenbach'ın görevini düşünün. Sınıflandırma, kuyruğun varlığı veya yokluğu, dar veya geniş göğüs, dik veya çömelmiş duruş ve daha az veya daha fazla zeka gibi çeşitli kriterlere bağlıdır. Bu tür hayvanları etiketlemek için eğitilmiş bir karar ağacı, her bir kriteri tek tek ele alacak ve sonuçta iki grubu ayıracaktır.

- Ağaç, şempanzeler, goriller ve orangutanların yanı sıra kapuçinler, babunlar ve marmosetlerden oluşan bir veri kümesindeki tüm örnekleri içerdiği görülebilen bir kök düğümle başlar. Kök, belirli bir özelliği sergileyen veya göstermeyen örnekler arasında bir seçim sunar ve bu özelliği olan ve olmayan örnekleri içeren iki alt düğüme yol açar. Her çocuk, iki çocuğa daha yol açan başka bir seçenek sunar ve bu böyle devam eder. İşlem, her biri çoğunlukla veya tamamen bir sınıfın örneklerini içeren herhangi bir sayıda yaprak düğümü ile sona erer.

- Ağacın büyümesi için kök kararını bulması gerekir. Seçim yapmak için tüm özellikleri ve bunların değerlerini (arka uzantı, göğüs kafesi vb.) göz önünde bulundurur ve bölünmenin saflığını en üst düzeye çıkaran birini seçer. (Optimal saflık, bir sınıfın belirli bir alt düğüme gitmesi ve hiçbirinin diğer düğüme gitmemesi örneklerinin yüzde 100'ü olarak tanımlanır.) Bölmeler, yalnızca bir karardan sonra nadiren yüzde 100 saftır ve oraya asla ulaşamayabilir, bu nedenle süreç devam eder, üretir. alt düğümlerin seviyesinden sonra, saflık daha fazla özellik göz önüne alındığında fazla yükselmeyene kadar. Bu noktada, ağaç tamamen eğitilmiştir.

- Çıkarımda, yeni bir örnek ağaçtan geçer ve her düzeyde yukarıdan aşağıya farklı bir kararı değerlendirir. Örnek, indiği yaprak düğümün içerdiği verilerin etiketini alır.

En iyi 10 isabet: 1986'da Avustralyalı bilgisayar bilimcisi John Ross Quinlan, ID3 ile ikili olmayan sonuçları desteklemek için karar ağaçlarını genişletti . 2008'de, C4.5 adlı bir başka iyileştirme , IEEE Uluslararası Veri Madenciliği Konferansı tarafından düzenlenen Veri Madenciliğinde En İyi 10 Algoritma listesinin üst sınırını oluşturdu.

Ormanın içine: Karar ağaçlarının bazı dezavantajları vardır. Yaprak düğümlerinin tek bir örnek kadar azını içerdiği kadar çok seviye büyüterek verileri kolayca aşabilirler. Daha da kötüsü, kelebek etkisine eğilimliler: Bir örneği değiştirin ve büyüyen ağaç çarpıcı biçimde farklı görünebilir. Bu özelliği bir avantaja çeviren Amerikalı istatistikçi Leo Breiman ve Yeni Zelandalı istatistikçi Adele Cutler, 2001 yılında rastgele ormanı geliştirdiler., her biri nihai bir karara oy veren farklı, örtüşen örnekler seçimini işleyen bir karar ağaçları topluluğu. Rastgele orman ve kuzeni XGBoost, fazla takmaya daha az eğilimlidir ve bu da onları en popüler makine öğrenimi algoritmaları arasında yer almasına yardımcı olur. Aristoteles, Porphyry, Blumenbach, Darwin, Jane Goodall, Dian Fossey ve diğer 1000 zoologun bir arada olması gibi, hepsi de sınıflandırmalarınızın olabileceklerinin en iyisi olduğundan emin oluyorlar.

K-Means Kümeleme: Grup Düşüncesi

Bir partide başkalarına yakın duruyorsanız, muhtemelen ortak bir noktanız vardır. Veri noktalarını gruplara ayırmak için k-Means kümelemeyi kullanmanın arkasındaki fikir budur. Gruplar ister insan gücüyle ister başka bir güçle oluşturulmuş olsun, bu algoritma onları bulacaktır.

Patlamalardan çevir sesine: Hem Bell Labs'in ikonik inovasyon fabrikasının hem de atom bombasını icat eden Manhattan Projesi'nin mezunu olan Amerikalı fizikçi Stuart Lloyd, dijital sinyaller içinde bilgi dağıtmak için ilk olarak 1957'de k-Means kümelemeyi önerdi. 1982'ye kadar yayınlamadı. Bu arada, Amerikalı istatistikçi Edward Forgy, 1965'te benzer bir yöntemi tanımladı ve alternatif adı Lloyd-Forgy algoritmasına yol açtı.

Merkezi bulma: Partiyi benzer düşünen çalışma gruplarına ayırmayı düşünün. Katılımcıların odadaki konumları ve oluşturulacak grupların sayısı göz önüne alındığında, k-ortalama kümelemesi katılımcıları kabaca eşit büyüklükte belirli sayıda gruba bölebilir.

- Eğitim sırasında, algoritma başlangıçta rastgele k kişi seçerek k küme merkez noktası veya merkez noktası belirler. (K manuel olarak seçilmelidir ve en uygun değeri bulmak her zaman önemsiz değildir.) Daha sonra her bir kişiyi en yakın ağırlık merkeziyle ilişkilendirerek k kümeyi büyütür.

- Her küme için, gruba atanan tüm kişilerin ortalama konumunu hesaplar ve ortalama konumu yeni ağırlık merkezi olarak belirler. Yeni merkezler bir kişi tarafından işgal edilmemiş olabilir, ama ne olmuş yani? İnsanlar çikolata fondü etrafında toplanma eğilimindedir.

- Algoritma, yeni merkez noktaları hesapladıktan sonra, bireyleri kendilerine en yakın olan merkeze yeniden atar. Sonra yeni merkezler hesaplar, kümeleri ayarlar, vb., merkezler (ve etrafındaki gruplar) artık kaymayana kadar.

- Oradan, yeni gelenleri doğru kümeye atamak kolaydır. Odadaki yerlerini almalarına ve en yakın ağırlık merkezini aramalarına izin verin.

Farklı mesafeler: Kümelenmiş nesneler arasındaki mesafenin uzamsal olması gerekmez. İki vektör arasındaki herhangi bir ölçü yapacaktır. Örneğin, parti müdavimlerini fiziksel yakınlığa göre gruplamak yerine, k-Means kümelemesi onları kıyafetlerine, mesleklerine veya diğer özelliklerine göre bölebilir. Çevrimiçi mağazalar, müşterileri tercihlerine veya davranışlarına göre bölmek için ve astronomlar da aynı türdeki yıldızları gruplamak için kullanır.

Veri noktalarının gücü: Fikir, birkaç dikkate değer varyasyon ortaya çıkardı:

- K-medoidler , belirli bir kümedeki ortalama konumlardan ziyade gerçek veri noktalarını merkezler olarak kullanır. Medoidler, kümelerindeki diğer tüm noktalara olan mesafeyi en aza indiren noktalardır. Bu varyasyon daha yorumlanabilir çünkü merkezler her zaman veri noktalarıdır.

- Fuzzy C-Means Clustering , veri noktalarının değişen derecelerde birden çok kümeye katılmasını sağlar. Sabit küme atamalarını, merkezlerden uzaklığa bağlı olarak üyelik dereceleriyle değiştirir.

N boyutta şenlik : Bununla birlikte, orijinal biçimindeki algoritma yaygın olarak yararlı olmaya devam ediyor - özellikle denetimsiz bir algoritma olarak, potansiyel olarak pahalı etiketli verilerin toplanmasını gerektirmediği için. Ayrıca kullanımı her zamankinden daha hızlı. Örneğin, scikit-learn'i içeren makine öğrenimi kitaplıkları, yüksek boyutlu verileri son derece hızlı bir şekilde bölümleyen 2002 kd ağaçlarının eklenmesinden yararlanır.